【线上培训】馆员AI素养培训:应用实践进阶篇——

“智慧图书馆技术应用讲座”2025年第7期(总第42期)

6月19日上午10点,2025年第7期云瀚“智慧图书馆技术应用讲座”(总第42期)成功在线上举行。本期讲座是“馆员AI素养培训”特别节目,目标是帮助馆员顺应时代潮流,高效掌握并应用人工智能技术,以推动图书馆的智慧化变革。本期讲座由来自深圳市海恒智能科技有限公司人工智能事业部总监、云瀚联盟技术委员会委员方洋,和福呈数据科技有限公司技术总监陈尚松担任主讲老师。超过1800人在线参加了本次讲座。

点击上方链接收看直播录像

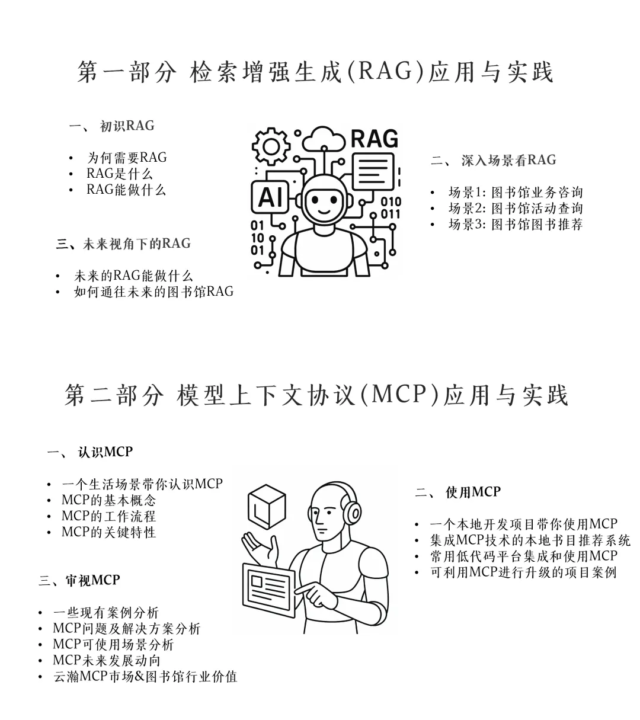

作为“馆员AI素养培训”系列的“应用实践进阶篇”,本期重点介绍了检索增强生成(RAG)和模型上下文协议(MCP)两大核心技术的应用实践方法。其中,RAG技术为模型获取外部知识,降低幻觉,提升准确性提供了可落地的路径;MCP技术则有效解决了大模型与外部数据的连接问题,为未来智能应用的能力拓展提供了广阔的前景。本次讲座课程大纲如下:

互动交流

在讲座的交流互动环节,现场和线上观众提问踊跃,部分精彩内容摘记如下。

问:我们图书馆现在的检索系统是老版本的,和RAG技术对接会不会很困难?需不需要更换整套系统?

方洋:无需立即更换系统。AI可将用户的自然语言问题转换为系统可识别的检索请求,提取关键参数并生成API请求,有效利用现有的系统进行检索。此外,AI还能基于书名、作者等基础信息实现推荐功能,与系统版本无关。因此,引入AI的关键在于检索系统的基本功能是否完备,而非其新旧程度。

问:RAG效果不好有什么优化方案吗?

方洋:有很多手段来提升RAG的效果。比如:通过文档分块策略优化,提升信息粒度合理性;引入重排序模型,二次筛选高相关片段;此外还有结合Agent机制,让模型自主选择知识源等。需注意优化方案会增加耗时,实际落地时要平衡准确性与响应速度的关系。现有方案已较成熟,关键是根据场景需求做针对性取舍。

问:使用低代码平台(如n8n、Dify)集成MCP时,最大的挑战是什么?

陈尚松:有这么几方面的挑战:一是不同的低代码平台工作流协议不同。我们在做老唱片查询时,图像识别的格式与n8n节点不匹配可能导致流程中断;另一个是算力资源环境的优化,例如处理图像/视频时,如果部署环境没有做更好的资源优化,工作流性能可能下降;第三是有一定开发门槛,例如有时需要定制适配器,这有一定技术要求。

问:RAG技术输出结果会不会出现冗余,有没有做限制?客户端可以限制吗?

方洋:RAG的结果冗余可通过后台优化控制,在客户端(读者端)难以直接限制。在后端,我们可以通过优化提示词和知识库来平衡信息完整性与简洁性。许多场景是通过持续的需求磨合和策略调整来实现最优效果。

问:智能体和MCP 的关系是什么?如何与MCP更好地结合?

陈尚松:首先,MCP可作为智能体的底层能力工具,集成调用各类具体功能;更进一步的结合方式是,让MCP成为认知助手,在处理底层数据时提取语义,基于目标导向进行决策与行动,通过标准化协议动态适配和优化场景,实现从功能集成到智能提升。

问:用户提问经语义分析后,系统执行和调用不同的MCP或知识库,在这种情况下,如果客户进行多轮问答,技术上如何实现上下文的准确理解?

陈尚松:用户提问时,语义分析引擎作为决策引擎,同时调用MCP模块池和知识库存储,结合结果后进行上下文更新与响应生成,存储到会话管理中,最终返回给语义引擎。这是一个完整的多轮问答机制。

方洋:补充两个小技巧。一是对多轮会话的最后一个问题进行重写或转写,使其更完整;二是将多轮问答直接交给大模型生成初步答案,从知识库中找到匹配文本块,再与上下文一起输入大模型优化回答,提升多轮问答准确率。需要注意的是,这些技巧还是要基于实际的落地场景进行具体调整。

课件下载

.png)